Elk jaar worden ongeveer 7 miljoen kinderen gemeld bij kinderwelzijnsinstanties voor mogelijk misbruik, maar hoe bepalen de autoriteiten of kinderen dit leuk vinden Gabriel Fernandez zijn in groot gevaar en hebben interventie nodig?

Veel kinderwelzijnsinstanties vertrouwen op de risicobeoordelingen van personeel dat is opgeleid om telefoonlijnen te beheren waar vermoedelijk misbruik wordt gemeld, maar sommigen geloven dat er misschien een betere manier is.

'Er is een grote hoeveelheid literatuur waarvan we hebben gezien dat deze suggereert dat mensen geen bijzonder goede kristallen bollen zijn', zegt Emily Putnam-Hornstein, directeur van de Datanetwerk voor kinderen en een universitair hoofddocent aan het USC, zei in de nieuwe Neflix docu-serie 'The Trials of Gabriel Fernandez.' 'Wat we in plaats daarvan zeggen, is dat we een algoritme gaan trainen om te bepalen welke van die kinderen passen in een profiel waarbij het lange boogrisico zou duiden op toekomstige systeembetrokkenheid.'

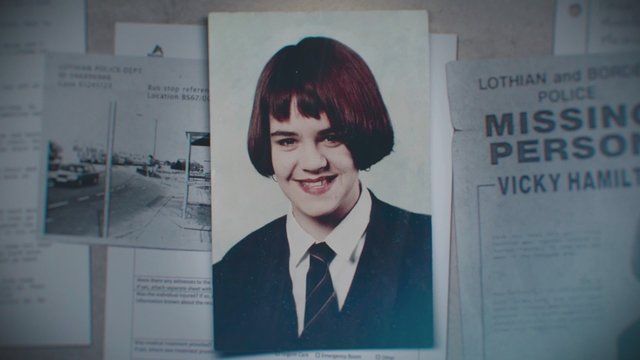

Fernandez was een 8-jarige jongen die door hem werd geslagen en doodgemarteld moeder en zij vriendje , ondanks herhaalde oproepen van zijn leraar en anderen aan autoriteiten die vermoedelijk misbruik melden. De nieuwe zesdelige serie onderzoekt het leven en de gruwelijke dood van Fernandez, maar neemt ook een grotere kijk op systemische problemen binnen het kinderwelzijnssysteem dat een rol had kunnen spelen.

Putnam-Hornstein stelt dat een strategie voor het effectiever identificeren van de kinderen die het grootste risico lopen, het gebruik van speciaal ontwikkelde algoritmen zou kunnen zijn die gebruik maken van administratieve dossiers en datamining om risicoscores voor elk kind te bepalen.

'We hebben in feite ongeveer 6 of 7 miljoen kinderen die elk jaar in de VS worden gemeld wegens vermeend misbruik of verwaarlozing, en historisch gezien is de manier waarop we sommige van onze screeningbeslissingen hebben genomen alleen gebaseerd op een soort darmevaluaties', zei ze. 'Voorspellende risicomodellering zegt gewoon: 'Nee, nee, nee, laten we dit op een meer systematische en empirische manier benaderen.' ''

Putnam-Hornstein en Rhema Vaithianathan, de mededirecteur van de Centrum voor analyse van sociale gegevens , konden het idee in Allegheny County, Pennsylvania, in praktijk brengen. Het paar gebruikte duizenden verwijzingen naar kindermishandeling om een algoritme te ontwerpen dat een risicoscore zou bepalen voor elk gezin dat werd gemeld aan de kinderbeschermingsdiensten van de provincie, volgens de Centrum voor gezondheidsjournalistiek

'Er wordt naar een honderdtal verschillende factoren gekeken', legt Marc Cherna, directeur van het Allegheny County Department of Human Services, uit in de docu-serie. 'Enkele fundamentele voorbeelden zijn de geschiedenis van het welzijn van kinderen, de geschiedenis van de ouders, zeker drugsgebruik en verslaving, psychische aandoeningen in het gezin, gevangenisstraf en veroordelingen, en vooral als er aanrandingen en dergelijke zijn.'

Vanwege het grote aantal telefoontjes hebben kinderwelzijnsinstanties in het hele land de taak om te bepalen of een gezin moet worden gescreend voor onderzoek op basis van de klacht, of moet worden gescreend.

In 2015 werd 42% van de 4 miljoen beschuldigingen die in het hele land werden ontvangen, waarbij 7,2 miljoen kinderen betrokken waren, gescreend, aldus De New York Times

Toch sterven er nog steeds kinderen door kindermishandeling.

Het systeem dat in Allegheny County wordt gebruikt, is ontworpen om nauwkeuriger te voorspellen welke gezinnen in de toekomst waarschijnlijk betrokken zullen zijn bij het systeem door middel van gegevensanalyse.

zijn ongesneden edelstenen gebaseerd op een echte persoon

'Wat screeners hebben, zijn veel gegevens', vertelde Vaithianathan aan The Times. 'Maar het is best moeilijk om te navigeren en te weten welke factoren het belangrijkst zijn. Met één telefoontje naar C.Y.F. , je hebt misschien twee kinderen, een vermeende dader, je hebt een moeder, je hebt misschien een andere volwassene in het huishouden - al deze mensen hebben een geschiedenis in het systeem die de persoon die de oproep screent, kan onderzoeken. Maar het menselijk brein is niet zo handig in het benutten en begrijpen van alle gegevens. '

De Allegheny-familiescreeningtool maakt gebruik van een statistische techniek genaamd 'datamining' om naar historische patronen te kijken om 'te proberen een voorspelling te doen over wat er zou kunnen gebeuren' in een bepaald geval, zei ze in de docu-serie.

Elk geval krijgt een risicoscore van 1 tot 20 - waarbij elk geval wordt gecategoriseerd als hoog risico, gemiddeld risico of laag risico.

Rachel Berger, kinderarts in het kinderziekenhuis van Pittsburgh, vertelde in 2018 aan The Times dat voorspellende analyse waardevol is omdat het een deel van de subjectiviteit elimineert die typisch in het proces zit.

'Al deze kinderen leven in chaos', zei ze. “Hoe gaat C.Y.F. uitzoeken welke het meeste gevaar lopen als ze allemaal risicofactoren hebben? Je kunt niet geloven hoeveel subjectiviteit er in de beslissingen over kinderbescherming zit. Daarom ben ik dol op voorspellende analyses. Het brengt eindelijk wat objectiviteit en wetenschap in beslissingen die zo ongelooflijk levensveranderend kunnen zijn. '

channon christian en christopher newsom foto's

Maar er zijn ook critici die beweren dat het gebruik van voorspellende analyses afhankelijk is van gegevens die mogelijk al bevooroordeeld zijn. Uit eerder onderzoek is gebleken dat minderheden en gezinnen met een laag inkomen vaak oververtegenwoordigd zijn in de gegevens die worden verzameld, wat volgens de docu-serie mogelijk een vooroordeel tegen Afro-Amerikaanse gezinnen of andere minderheidsfamilies creëert.

“De menselijke vooroordelen en gegevensvooroordelengaan hand in hand met elkaar, ”Zei Kelly Capatosto, een senior onderzoeksmedewerker bij het Kirwan Institute for the Study of Race and Ethnicity aan de Ohio State University, volgens het Center for Health Journalism. “Bij deze beslissingen denken we na over bewaking en systeemcontact - met politie, kinderwelzijnsinstanties, eventuele hulpverlenende instanties. Het zal oververtegenwoordigd zijn in gemeenschappen (met lage inkomens en minderheden). Het is niet noodzakelijk een indicatie van waar deze gevallen plaatsvinden. '

Erin Dalton, adjunct-directeur van het bureau voor analyse, technologie en planning van Allegheny County, gaf toe dat vooringenomenheid mogelijk is.

“Zeker, er zit een vooroordeel in onze systemen. Kindermishandeling wordt door ons en onze gegevens gezien als geen functie van feitelijk kindermishandeling, het is een functie van wie er wordt gemeld '', zei ze in de Netflix-serie.

Maar de provincie vertelde het Center for Health Journalism ook dat het heeft ontdekt dat het ontvangen van overheidsuitkeringen de risicoscores van bijna haar gezinnen verlaagt.

TDe provincie is 'erg gevoelig' voor die bezorgdheid en doet voortdurende analyse van het systeem om te bepalen of groepen onevenredig het doelwit zijn, zei Cherna ook in de docu-serie.

Het Allegheny County-systeem is eigendom van de provincie zelf, maar er is ook enige kritiek op andere particuliere screening-systemen.

Het Illinois Department of Children and Family Services kondigde in 2018 aan dat het niet langer een voorspellend analysepakket zou gebruiken dat is ontwikkeld door Eckerd Connects, een non-profitorganisatie, en zijn winstgevende partner MindShare Technology, deels omdat het bedrijf weigerde details te verstrekken over welke factoren werden volgens The Times in hun formule gebruikt.

Het systeem begon naar verluidt duizenden kinderen aan te wijzen die dringend bescherming nodig hadden, waardoor meer dan 4.100 kinderen uit Illinois een kans van 90 procent of meer op overlijden of letsel hadden, De Chicago Tribune gerapporteerd in 2017.

Toch stierven andere kinderen die geen hoge risicoscores kregen als gevolg van misbruik.

'Voorspellende analyses voorspelden geen van de slechte gevallen', zegt Beverly, directeur van het Department of Children and Family Services, 'B.J.' Walker vertelde de tribune. 'Ik heb besloten om niet door te gaan met dat contract.'

Daniel Hatcher, auteur van ' The Poverty Industry: The Exploitation of America's meest kwetsbare burgers 'Vergeleek sommige analysesystemen met een' zwarte doos ', en zei in de docu-serie dat het niet altijd duidelijk is hoe ze hun beslissingen nemen.

'Ze hebben geen manier om erachter te komen hoe ze daadwerkelijk een zorgniveau bepalen dat een enorme impact heeft op een individu', zei hij.

Putnam-Hornstein erkende dat de voorspellende analytische systemen niet in staat zijn om toekomstig gedrag te bepalen, maar ze gelooft wel dat het een waardevol hulpmiddel is waarmee screeners weloverwogen beslissingen kunnen nemen over welke kinderen het grootste risico lopen.

'Ik hoop dat deze modellen ons systeem zullen helpen om meer aandacht te besteden aan de relatief kleine subset van verwijzingen waar het risico bijzonder hoog is, en we zullen in staat zijn om meer middelen aan die kinderen en gezinnen te besteden op een preventieve manier', zei ze. aan het Centrum voor gezondheidsjournalistiek. 'Ik wil niet dat iemand de voorspellende risicomodellering te veel verkoopt. Het is geen kristallen bol. Het lost niet al onze problemen op. Maar aan de rand, als het ons in staat stelt om iets betere beslissingen te nemen en de gevallen met een hoog risico te identificeren en die uit de gevallen met een laag risico te scheiden en dienovereenkomstig aan te passen, zou dit een belangrijke ontwikkeling in het veld kunnen zijn. '